신경망에서의 경사하강법 구현

신경망은 학습 시에 최적의 매개변수(가중치와 편향)을 찾아냅니다. 여기서 최적이란 손실 함수가 최솟값이 될 때 매개변수의 값입니다. 그러나 매개변수 공간은 광대하여 어디가 최솟값인지 찾기 힘듭니다. 이런 상황에서 기울기를 잘 이용해 함수의 최솟값 혹은 가장 근접한 값을 함수 값을 점차 줄임으로써 찾으려고 하는 것이 경사법입니다.

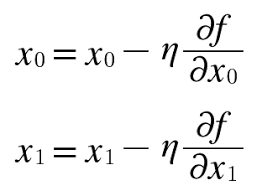

η(에타)는 신경망에서 학습률입니다. 학습률은 한 번의 학습으로 얼만큼 학습해야 할지, 즉, 매개변수를 얼마다 업데이트할지 정하는 것입니다. 위 식처럼 변수값을 갱신하는 단계를 여러번 거치며 서서히 함수의 값을 줄입니다. 학습률은 0.01,0.001과 같ㅌ이 특정 값을 정해야합니다. 너무 크거나 작으면 좋은 장소를 찾아갈 수 없습니다. 보통은 이 학습률을 변경하면서 올바르게 학습하고 있는지 확인하면서 진행합니다.

def gradient_descent(f, init_x, lr=0.01, step_num=100):

x = init_x

for i in range(step_num):

grad = numerical_gradient(f,x)

return xf는 최적화하려는 함수, step_num은 경사법에 따른 반복 횟수 입니다. 함수의 기울기는 numerical_gradient로 구하고, 그 기울기에 학습률을 곱한 값으로 업데이트라는 과정은 step_num만큼 반복합니다.

학습률같은 매개변수를 하이퍼파라미터라고 합니다. 이는 가중치, 편향과같은 신경망의 매개변수롸는 성질이 다른 변수입니다. 신경망의 가중치는 훈련데이터와 알고리즘에 의해 자동으로 획득되는 매개변수인 반면, 하이퍼파라미터는 사람이 직접 설정해야하는 변수입니다. 일반적으로 이 하이퍼파라미터들음 여러 후보 값 중에서 시험을 통해 가장 잘 학습이 되는 값을 찾는 과정을 필요로 합니다.