[딥러닝] 초음파 광물 데이터 : 과적합 피하기

import pandas as pd

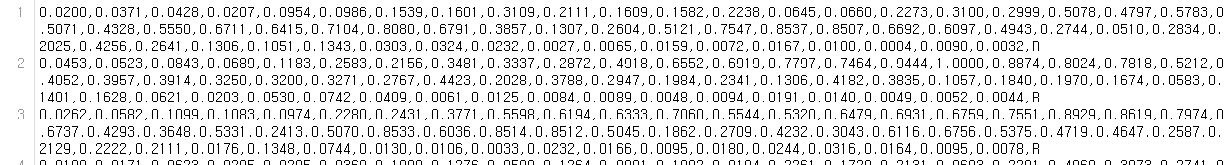

df = pd.read_csv(’../dataset/sonar.csv’, header=None)

print(df.info())

|

Range Index: 208 entries,0 to 207 |

|||

|

Data columns (total 61 columns): |

|||

|

0 |

208 |

non-null |

float64 |

|

1 |

208 |

non-null |

float64 |

|

… |

… |

… |

… |

|

59 |

208 |

non-null |

float64 |

|

60 |

208 |

non-null |

object |

|

Dtypes: float64(60), object(1) |

|||

|

memory usage: 99.2+ KB |

|||

Index가 208개이므로 총 샘플의 수는 208개이고, 컬럼 수가 61개이므로 60개의 속성과 1개의 클래스로 이루어져 있음

모든 컬럼이 실수형(float64)인데, 맨 마지막 컬럼만 객체형인 것으로 보아,

마지막에 나오는 컬럼은 클래스이며 데이터형 변환이 필요한 것을 알 수 있음

from keras.models import Sequential

from keras.layers.core import Dense

from sklearn.preprocessing import LabelEncoder

import pandas as pd

import numpy

import tensorflow as tf

# seed 값 설정

numpy.random.seed(3)

tf.random.set_seed(3)

# 데이터 입력

df = pd.read_csv('../dataset/sonar.csv', header=None)

'''

# 데이터 개괄 보기

print(df.info())

# 데이터의 일부분 미리 보기

print(df.head())

'''

dataset = df.values

X = dataset[:,0:60]

Y_obj = dataset[:,60]

# 문자열 변환

e = LabelEncoder()

e.fit(Y_obj)

Y = e.transform(Y_obj)

# 모델 설정

model = Sequential()

model.add(Dense(24, input_dim=60, activation='relu'))

model.add(Dense(10, activation='relu'))

model.add(Dense(1, activation='sigmoid'))

# 모델 컴파일

model.compile(loss='mean_squared_error',

optimizer='adam',

metrics=['accuracy'])

# 모델 실행

model.fit(X, Y, epochs=200, batch_size=5)

# 결과 출력

print("\n Accuracy: %.4f" % (model.evaluate(X, Y)[1]))Accuracy: 1.0000

정말로 100% 정확도의 모델이 만들어진 것일까?

과적합(overfitting) : 모델이 학습 데이터셋 안에서는 일정 수준 이상의 예측 정확도를 보이지만, 새로운 데이터에 적용하면 잘 맞지 않는 것

완전히 새로운 데이터에 적용하면 이 선을 통해 정확히 두 그룹으로 나누지 못하게 된다

초록색 선은 과적합된 모델을, 검은색 선은 일반 모델을 나타낸다.

과적합은 층이 너무 많거나 변수가 복잡해서 발생하기도 하고 테스트셋과 학습셋이 중복될 때 생기기도 한다.

과적합을 방지하려면 ?

1. 학습을 하는 데이터셋과 이를 테스트할 데이터셋을 완전히 구분한 다음 학습과 동시에 테스트를 병행하며 진행

예를 들어, 데이터셋이 총 100개의 샘플로 이루어져 있다면 다음과 같이 두 개의 셋으로 나눕니다.

|

70개 샘플은 학습셋으로 |

30개 샘플은 테스트셋으로 |

신경망을 만들어 70개의 샘플로 학습을 진행한 후 이 학습의 결과를 저장=‘모델’

모델은 다른 셋에 적용할 경우 학습 단계에서 각인되었던 그대로 다시 수행, 따라서 나머지 30개의 샘플로 실험해서 정확도를 살펴보면 학습이 얼마나 잘 되었는지를 알 수 있음

딥러닝 같은 알고리즘을 충분히 조절하여 가장 나은 모델이 만들어지면, 이를 실생활에 대입하여 활용하는 것이 바로 머신러닝의 개발 순서

그런데 지금까지 우리는 테스트셋을 만들지 않고 학습해 왔습니다. 그런데도 매번 우리는 정확도(Accuracy)를 계산할 수 있었지요. 어째서 가능했을까요? 지금까지 학습 데이터를 이용해 정확도를 측정한 것은 데이터에 들어있는 모든 샘플을 그대로 테스트에 활용한 결과입니다.

학습에 사용된 샘플은 테스트에 쓸 수 없으므로 학습 단계에서 테스트할 샘플은 자동으로 빼고, 이를 테스트한 결과를 모아 정확도를 계산하는 것이지요. 이러한 방법은 빠른 시간에 모델 성능을 파악하고 수정할 수 있도록 도와 줍니다.

하지만 머신러닝의 최종 목적은 과거의 데이터를 토대로 새로운 데이터를 예측하는 것입니다. 즉, 테스트셋을 만들어 정확한 평가를 병행하는 것이 매우 중요합니다. 학습셋만 가지고 평가할때, 층을 더하거나 에포크(epoch) 값을 높여 실행 횟수를 늘리면 정확도가 계속해서 올라갈 수 있습니다. 하지만 학습 데이터셋만으로 평가한 예측 성공률이 테스트셋에서도 그대로 나타나지는 않습니다. 즉, 학습이 깊어져서 학습셋 내부에서의 성공률은 높아져도 테스트셋에서는 효과가 없다면 과적합이 일어나고 있는 것이지요. 이를 그래프로 표현하면

학습을 진행해도 테스트 결과가 더 이상 좋아지지 않는 지점에서 학습을 멈춰야 합니다. 이때의 학습 정도가 가장 적절한 것으로 볼 수 있습니다.

예제에 주어진 데이터를 학습셋과 테스트셋으로 나누는 예제를 만들어 보겠습니다. 불러온 X 데이터와 Y 데이터에서 각각 정해진 비율(%)만큼 구분하여 한 그룹은 학습에 사용하고 다른 한 그룹은 테스트에 사용하게 하는 함수가 sklearn 라이브러리의 train_test_split() 함수입니다. 따라서 다음과 같이 학습셋과 테스트셋을 만들 수 있습니다. 학습셋을 70%, 테스트셋을 30%로 설정했을 때의 예입니다.

from sklearn.model_selection import train_test_split

# 학습셋과 테스트셋의 구분

X_train, X_test, Y_train, Y_test = train_test_split(X, Y, test_size=0.3, random_state=seed)그리고 모델을 실행하는 부분에서 위에서 만들어진 학습셋으로 학습을, 테스트셋으로 테스트를 하게 하려면 다음과 같이 실행합니다.

model.fit(X_train, Y_train, epochs=130, batch_size=5)

# 테스트셋에 모델 적용

print("\n Test Accuracy: %.4f" % (model.evaluate(X_test, Y_test)[1]))

학습이 끝난 후 테스트해 본 결과가 만족스러울 때 이를 모델로 저장하여 새로운 데이터에 사용할 수 있습니다.

앞서 학습한 결과를 모델로 저장하려면 다음과 같이 실행합니다.

from keras.models import load_model

model.save(‘my_model.h5’)불러오기:

model = load_model(‘my_model.h5’)

전체 코드

from keras.models import Sequential, load_model

from keras.layers.core import Dense

from sklearn.preprocessing import LabelEncoder

import pandas as pd

import numpy

import tensorflow as tf

# seed 값 설정

seed = 0

numpy.random.seed(seed)

tf.random.set_seed(3)

df = pd.read_csv('../dataset/sonar.csv', header=None)

dataset = df.values

X = dataset[:,0:60]

Y_obj = dataset[:,60]

e = LabelEncoder()

e.fit(Y_obj)

Y = e.transform(Y_obj)

# 학습셋과 테스트셋을 나눔

from sklearn.model_selection import train_test_split

X_train, X_test, Y_train, Y_test = train_test_split(X, Y, test_size=0.3, random_state=seed)

model = Sequential()

model.add(Dense(24, input_dim=60, activation='relu'))

model.add(Dense(10, activation='relu'))

model.add(Dense(1, activation='sigmoid'))

model.compile(loss='mean_squared_error', optimizer='adam', metrics=['accuracy'])

model.fit(X_train, Y_train, epochs=130, batch_size=5)

model.save('my_model.h5') # 모델을 컴퓨터에 저장

del model # 테스트를 위해 메모리 내의 모델을 삭제

model = load_model('my_model.h5') # 모델을 새로 불러옴

print("\n Test Accuracy: %.4f" % (model.evaluate(X_test, Y_test)[1])) # 불러온 모델로 테스트 실행Test Accuracy: 0.8095

k겹 교차 검증

딥러닝 혹은 머신러닝 작업을 할 때 늘 어려운 문제 중 하나는 알고리즘을 충분히 테스트하였어도 데이터가 충분치 않으면 좋은 결과를 내기가 어렵다는 것입니다. 앞서 가지고 있는 데이터의 약 70%를 학습셋으로 써야 했으므로 테스트셋은 겨우 전체 데이터의 30%에 그쳤습니다. 이 정도 테스트만으로는 실제로 얼마나 잘 작동하는지 확신하기는 쉽지 않습니다.

이러한 단점을 보완하고자 만든 방법이 바로 k겹 교차 검증(k-fold cross validation)입니다.

k겹 교차 검증이란 데이터셋을 여러 개로 나누어 하나씩 테스트셋으로 사용하고 나머지를 모두 합해서 학습셋으로 사용하는 방법입니다. 이렇게 하면 가지고 있는 데이터의 100%를 테스트셋으로 사용할 수 있습니다.

예를 들어, 5겹 교차 검증(5-fold cross validation):

sklearn의 StratifiedKFold() : 데이터를 원하는 숫자만큼 쪼개 각각 학습셋과 테스트셋으로 사용되게 만드는 함수

from sklearn.model_selection import StratifiedKFold

n_fold = 10

skf = StratifiedKFold(n_splits=n_fold, shuffle=True, random_state=seed)

10개의 파일로 쪼개 테스트하는 10겹 교차 검증.

n_fold의 값을 10으로 설정한 뒤 StratifiedKFold() 함수에 적용.

그 다음 모델을 만들고 실행하는 부분을 for 구문으로 묶어 n_fold만큼 반복

for train, test in skf.split(X, Y):

model = Sequential()

model.add(Dense(24, input_dim=60, activation=‘relu’))

model.add(Dense(10, activation=‘relu’))

model.add(Dense(1, activation=‘sigmoid’))

model.compile(loss=‘mean_squared_error’, optimizer=‘adam’, metrics=[‘accuracy’])

model.fit(X[train], Y[train], epochs=100, batch_size=5)

정확도(Accuracy)를 매번 저장하여 한 번에 보여줄 수 있게 accuracy 배열을 만듭니다

accuracy = []

for train, test in skf.split(X, Y):

(중략)

k_accuracy = "%.4f" % (model.evaluate(X[test], Y[test])[1])

accuracy.append(k_accuracy)

print("\n %.f fold accuracy:" % n_fold, accuracy)

전체 코드

from keras.models import Sequential

from keras.layers.core import Dense

from sklearn.preprocessing import LabelEncoder

from sklearn.model_selection import StratifiedKFold

import numpy

import pandas as pd

import tensorflow as tf

# seed 값 설정

seed = 0

numpy.random.seed(seed)

tf.set_random_seed(seed)

df = pd.read_csv('../dataset/sonar.csv', header=None)

dataset = df.values

X = dataset[:,0:60]

Y_obj = dataset[:,60]

e = LabelEncoder()

e.fit(Y_obj)

Y = e.transform(Y_obj)

# 10개의 파일로 쪼갬

n_fold = 10

skf = StratifiedKFold(n_splits=n_fold, shuffle=True, random_state=seed)

# 빈 accuracy 배열

accuracy = []

# 모델의 설정, 컴파일, 실행

for train, test in skf.split(X, Y):

model = Sequential()

model.add(Dense(24, input_dim=60, activation='relu'))

model.add(Dense(10, activation='relu'))

model.add(Dense(1, activation='sigmoid'))

model.compile(loss='mean_squared_error', optimizer='adam', metrics=['accuracy'])

model.fit(X[train], Y[train], epochs=100, batch_size=5)

k_accuracy = "%.4f" % (model.evaluate(X[test], Y[test])[1])

accuracy.append(k_accuracy)

# 결과 출력

print("\n %.f fold accuracy:" % n_fold, accuracy)

실행 결과

10 fold accuracy: ['0.8182', '0.7143', '0.8095', '0.8095', '0.7619', '0.8095', '0.8571', '0.9500', '0.7500', '0.8000']

10번의 테스트값 출력됨