#스스로 공부하고 만든 내용입니다.

BERT : Pre-training of Deep Bidirectional Transformers for Language Understanding

https://arxiv.org/abs/1810.04805 (원문)

이전 글과 이어지는 내용입니다.

- Introduction & Related Works

- Pre-training

- Fine-tuning

- Experiment

- Conclusion + koBert

BERT는 문맥을 반영한 임베딩(Conatextual Embedding)을 가능하게 해주는 범용 언어 표현 모델입니다.

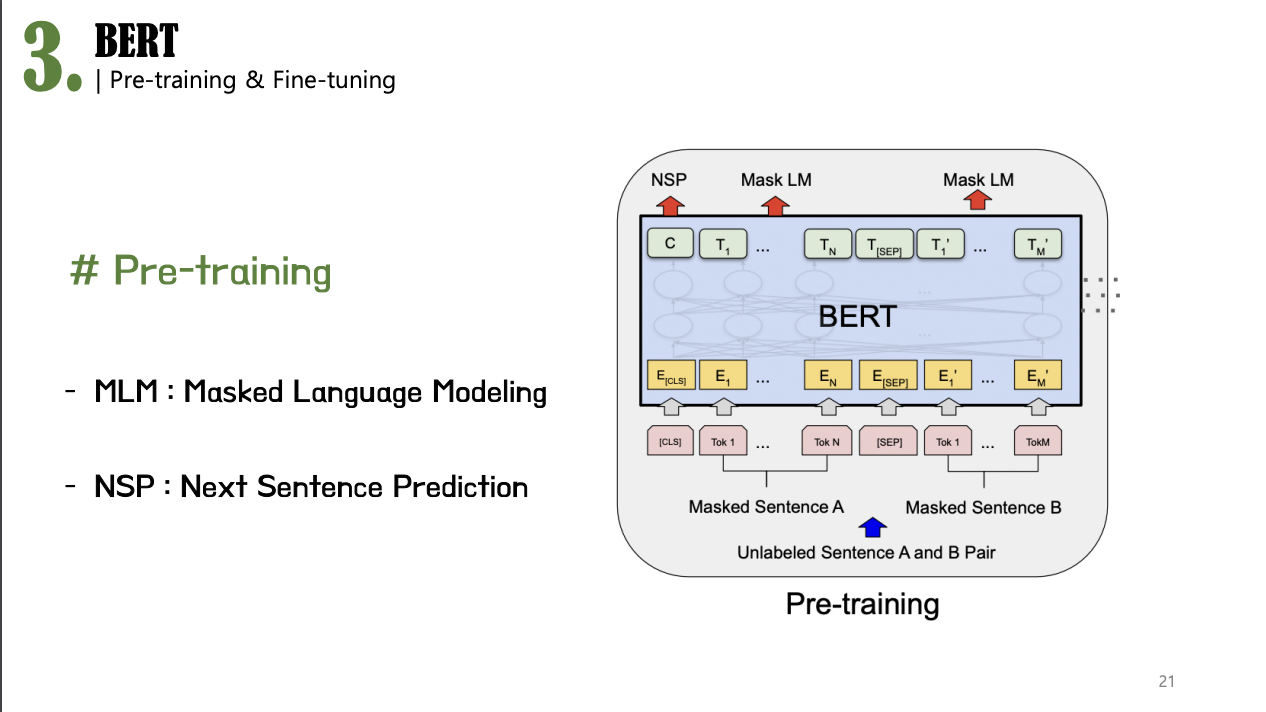

BERT는 크게 pre-training(사전 학습), fine-tuning(미세 조정) 두 단계로 나눌 수 있습니다.

Pre-training 단계에서 위키피디아와 같이 레이블이 없는 방대한 데이터(말뭉치,corpus)로 사전 훈련을 시킨 모델을 가지고 fine-tuning 단계로 넘어가, 여러 자연어 처리 테스크에서 추가 학습과 함께 하이퍼파라미터(hyper-parameter)를 재조정합니다.

위 그림에서 pre-training에서 input으로 들어가는 라벨링 되지 않은 문장 A와 B의 쌍은 input sequence, 분홍색 박스는 input sequence들이 토큰화된 토큰을 의미합니다. 그 위에 노란색 박스는 그 토큰들이 임베딩 레이어를 거친, 임베딩 벡터이고, 신경망을 거 그상단의 초록색 박스인 최종 은닉 벡터가 나오게 됩니다.

BERT의 모델 구조를 보면, BERT는 트랜스포머의 인코더 부분만을 여러 층으로 쌓았다는 것을 알 수 있습니다.

논문은 2가지 표준 구조 모델, BERT_base와 BERT_large를 보여줍니다. 두 모델의 구조적인 차이를 보면,

BERT_base는 트랜스포머 인코더를 12개의 층으로 쌓은 구조를 가지고 있고, BERT_large는 24개의 층으로 쌓아올린 구조를 가지고 있습니다. BERT_base의 구조는 기존에 존재하던 OpenAI GPT와의 성능 비교를 위해 고안된 모델이기에, OpenAI GPT와 동일한 모델 크기를 갖도록 설계되었고, BERT_large는 BERT의 성능 구조를 극대화한 모델로, BERT가 달성한 SOTA는 BERT_large로부터 나온 결과라고 보시면 됩니다.

# 문장(sentence) 시퀀스(sequence) 재정의

두 단어는 해당 논문에서 우리가 일반적으로 아는 것과는 조금 다르게 정의하고 있기 때문에 각 단어의 정의를 짚어보자면, 일반적으로 저희가 알고 있는 문장(sentence)은 주어와 서술어를 갖추고 있는 언어학적 의미에서의 문장이지만, 해당 논문에서 정의하는 문장(sentence)는 연속적인 단어들 혹은 텍스트들의 나열을 의미합니다. (연속된 텍스트들의 임의의 범위)

따라서, 여기서 이야기하는 문장은 구가 될 수도 있고, 문장이나 문단이 될 수 있습니다.

시퀀스(sequence)는 BERT의 인풋 토큰 시퀀스로, 앞서 정의한 문장을 기반으로, 단일 문장 혹은 문장 쌍을 의미합니다.

다시 BERT의 input 과정으로 돌아와서, BERT는 라벨링되지 않은 단일 문장이나 문장 쌍을“하나의 토큰 시퀀스”로 input을 받게 되는데,

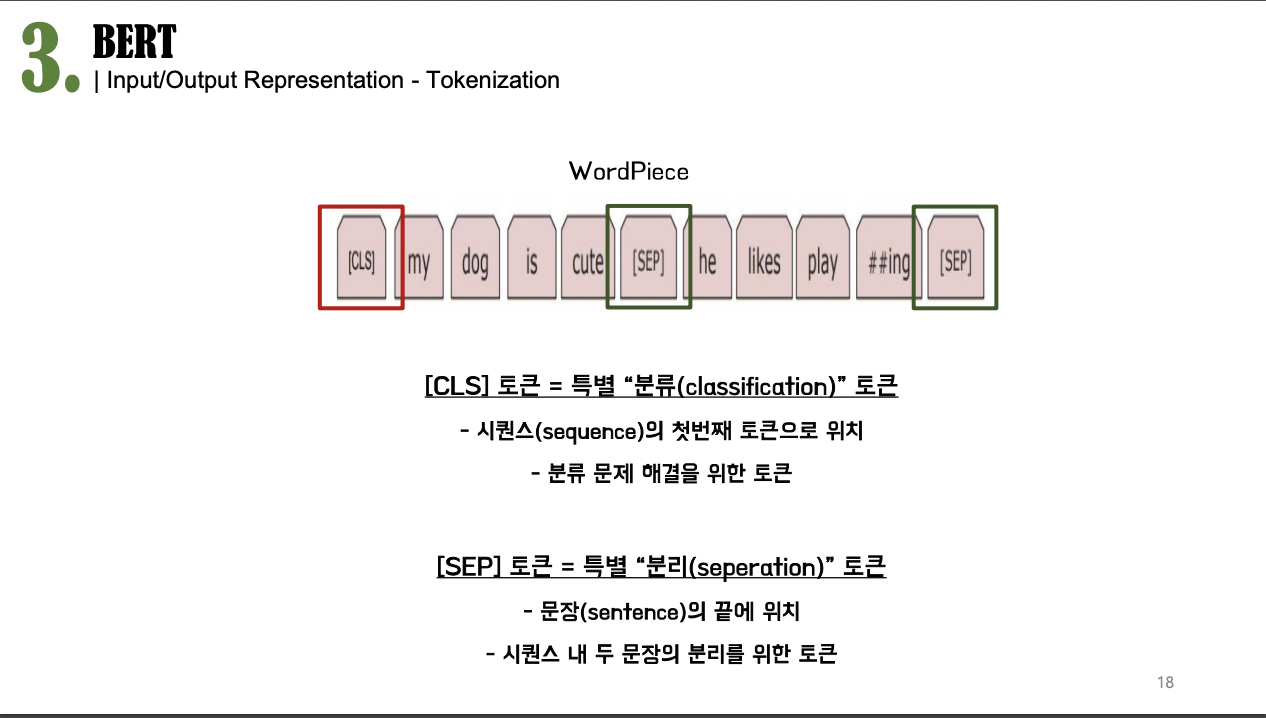

토큰화의 과정에서 BERT는 WordPiece 토크나이저를 사용하게 됩니다.

# Workpiece Tokenizer

WordPiece 토크나이저는 기존의 단어 단위로 토큰화 하는 것보다 한 층 더 나아가서,

어휘 사전에 없는 단어들에 대해 “## ing”와 같이언어적 의미를 유지하는 한도 내에서 “하위 단어” 단위로 분할해 텍스트를 토큰화 하는 겁니다. 이렇게 토큰화를 진행하게 되면 모델이 인풋으로 들어온 특정 단어에 대해 알지 못하는 경우에 기존처럼 단순히 “unknown”으로 처리해버리는 것이 아니라, 개별 “하위 단어” 토큰을 통해 어느 정도 의미를 추론할 수 있도록 하고, 그로 인해 새로운 단어에 대한 예측도 가능하게 되면서정확도를 좀 향상 시켜주는 장점이 있습니다.

토크나이징 된 토큰들에는 [CLS]라고 하는 특별 “분류” 토큰과 [SEP]라고 하는 특별 “분리” 토큰이 붙게됩니다.

[CLS] 토큰은 모든 시퀀스의 첫번째 토큰으로 위치하여 시퀀스의 시작과 끝을 알리고, 분류 테스크에서 활용되게 됩니다.

반면에 [SEP] 토큰은 모든 문장의 끝에 추가되어, 한 시퀀스를 구성하고 있는 두 문장쌍을 분리해주는 역할을 하게 됩니다.

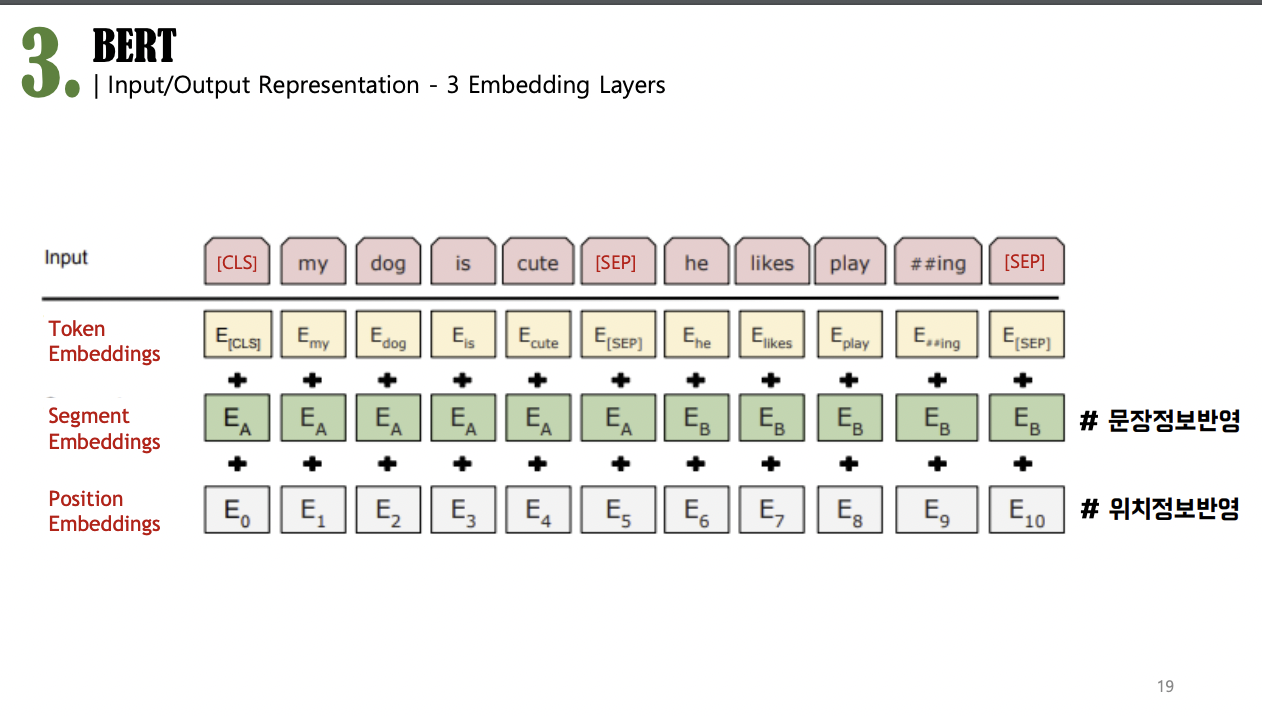

이렇게 토큰화가 완료된 각 토큰들은 3가지 임베딩 레이어를 기반으로 임베딩되어 BERT의 인풋으로 들어가게 되는데,

위 그림과 같이,

최종 인풋 임베딩(Input Embedding) = 토큰 임베딩(Token Embedding)+세그멘테이션 임베딩(Segmentation Embedding)+ 포지션 임베딩(Position Embedding)을 거쳐 인풋 임베딩으로 들어가게 됩니다.

각 임베딩값이 더해지는 이유는 BERT는 기본적으로 transformer encoder의 구조를 가지고 있기 때문에 모든 단어를 병렬로 처리하므로 단어가 가지고 있는 위치 정보를 최대한 반영해줄 수 있는 positional embedding값을 더해주고, 또한 문장 레벨의 테스크를 해결하는 경우, 각 토큰이 어느 문장에 포함되어 있는지에 대한 정보 또한 필요하기 때문에, [SEP] 토큰과 더불어 문장 정보를 반영해주는 segmentation embedding 값도 함께 더해주게 됩니다.

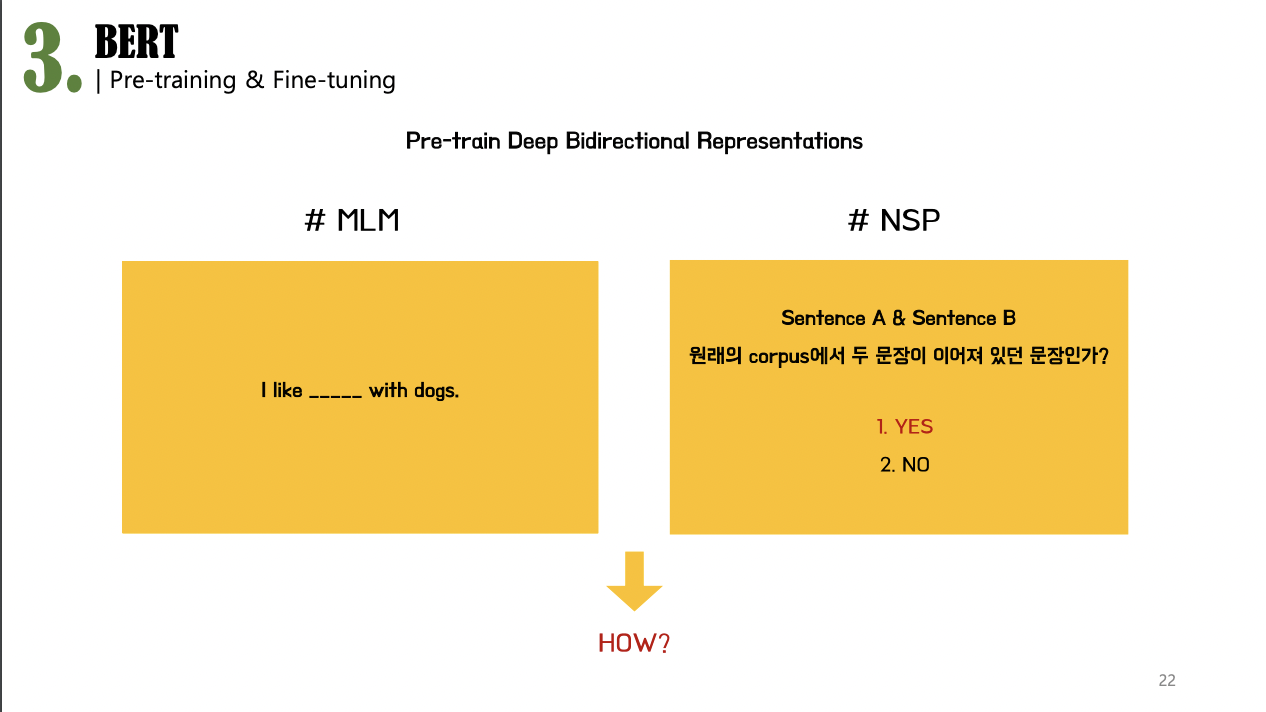

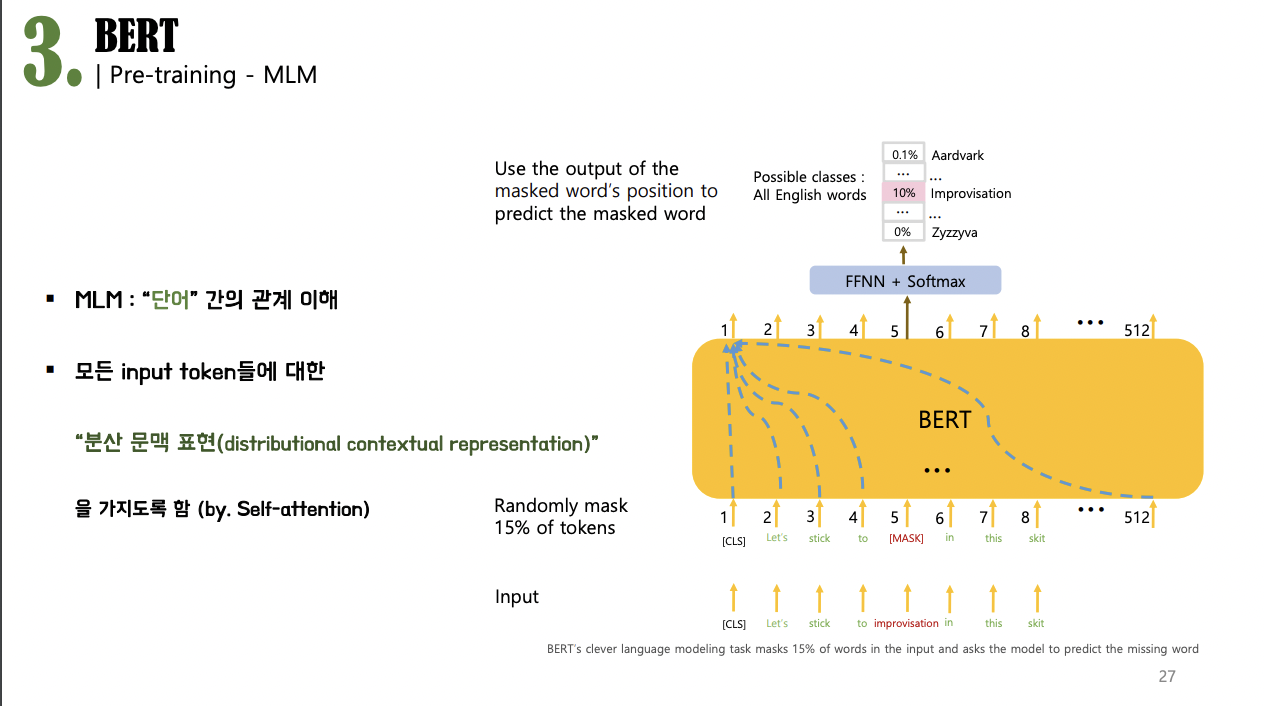

BERT의 pre-training 방법은 MLM( Masked Language Modeling) 과 NSP(Next Sentence Prediction) 입니다.

비유하자면, MLM은 흔히 빈칸맞추기 문제라고 생각하시면 되고, NSP는 두 문장이 주어졌을 때, 그 두 문장이 서로 이어지는 문장인지 아닌지를 맞춰야 하는 문제라고 할 수 있습니다.

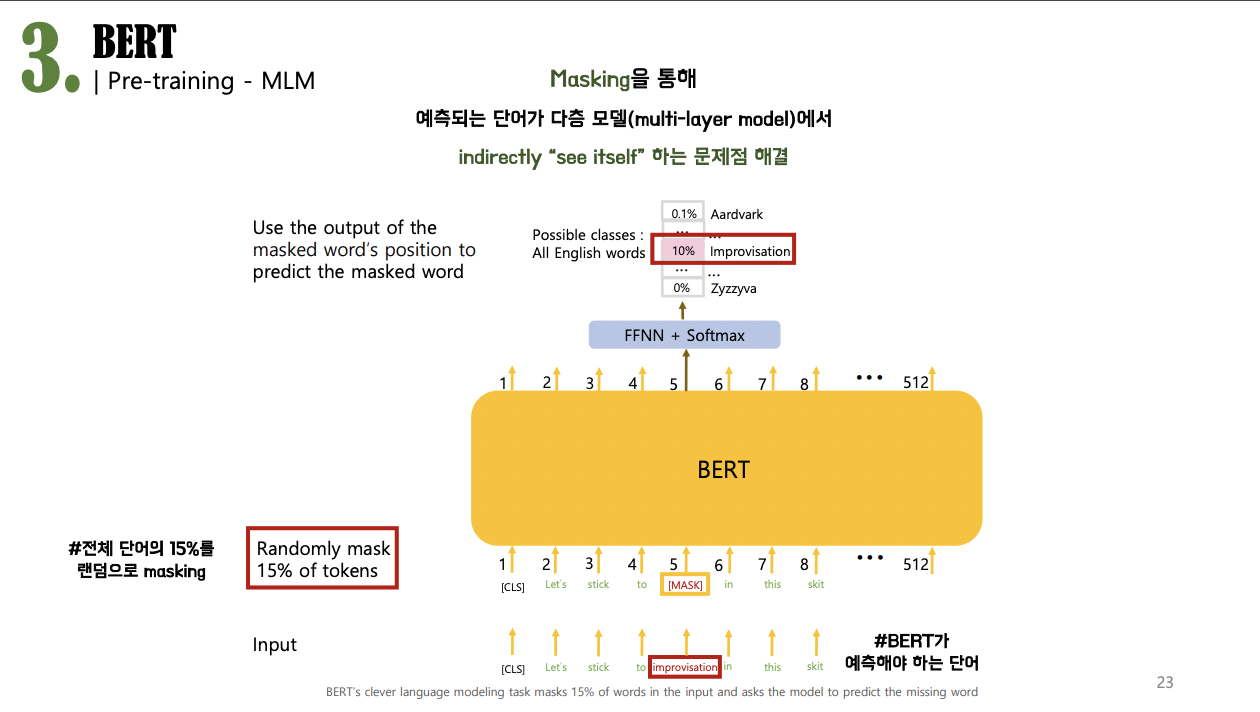

# MLM( 마스크드 언어 모델링)

기본적으로 문맥 모델들은 문장의 다른 단어들을 기반으로 각 단어의 표현을 생성합니다. 그러나 ELMo와 같이 각 단어를 단순히 이전 단어와 다음 단어에 기반하여 훈련시키는 것은 깊은 양방향 모델로 형성하는 것이 불가능했습니다. 왜냐하면 이는 예측되는 단어가 다층 모델에서 간접적으로 자신을 볼 수 있기 때문에 cheating이 가능해서 깊은 양방향 모델로 만들어 내는 것은 불가능하기 때문입니다.

이러한 문제점을 해결하기 위해, 입력의 일부 단어를 랜덤으로 마스킹을 하는 것이 MLM 입니다.

입력의 일부 단어를, 정확하게 말하자면 전체 단어의 15%를 랜덤으로 마스킹한 다음에 각 단어를 양방향으로 훈련하여

BERT가 그 마스킹된 단어만을 예측해서 맞추도록 하는 기술을 사용하게 됩니다.(전체예측X)

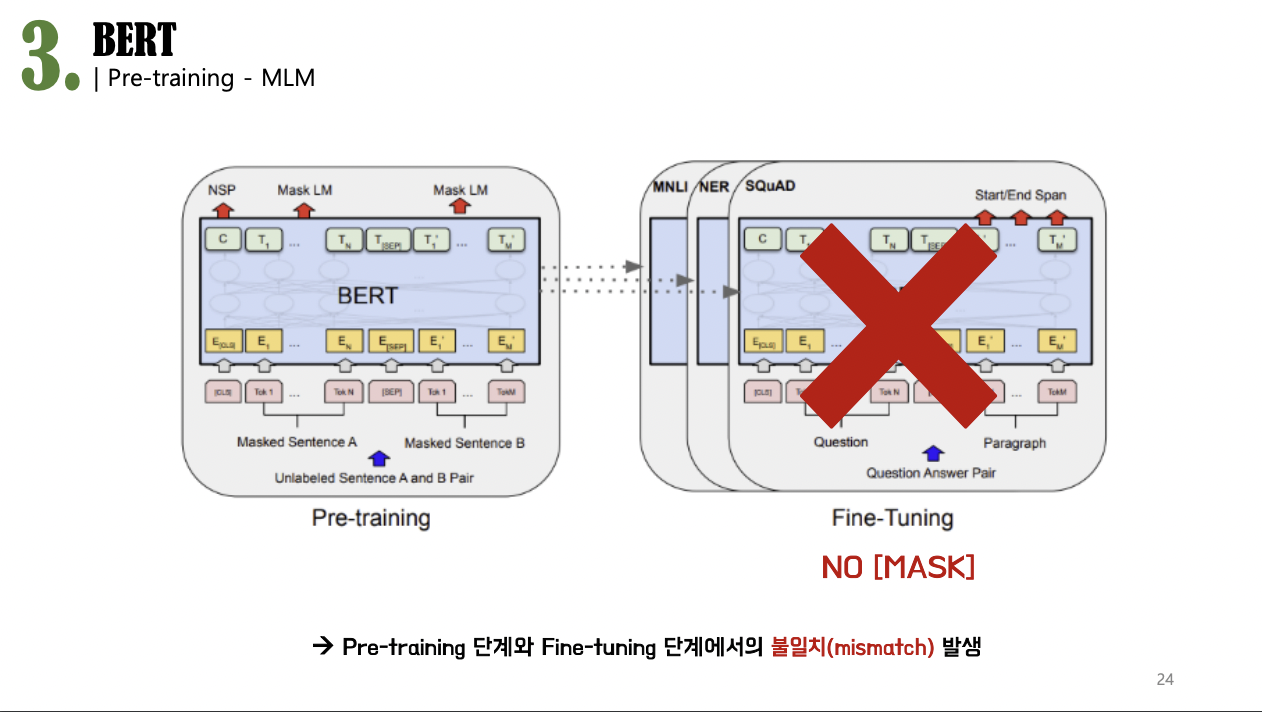

MLM으로 BERT는 cheating 없이 더 정확하게 단어를 예측하는 훈련으로 깊은 양방향성을 지닌 사전 훈련 모델이 될 수 있었을 것 같았지만, 한 가지 문제점이 더 발생하게 됩니다.

이렇게 사전 훈련 단계에서는 잘 나타나는 [MASK] 토큰이 이후에 설명드릴 fine-tuining 단계에서는 나타나지 않는 문제점이었는데,

이는 사전 훈련 단계와 파인 튜닝 단계에서의 불일치를 유발하여 학습에 문제가 발생하게 됩니다.

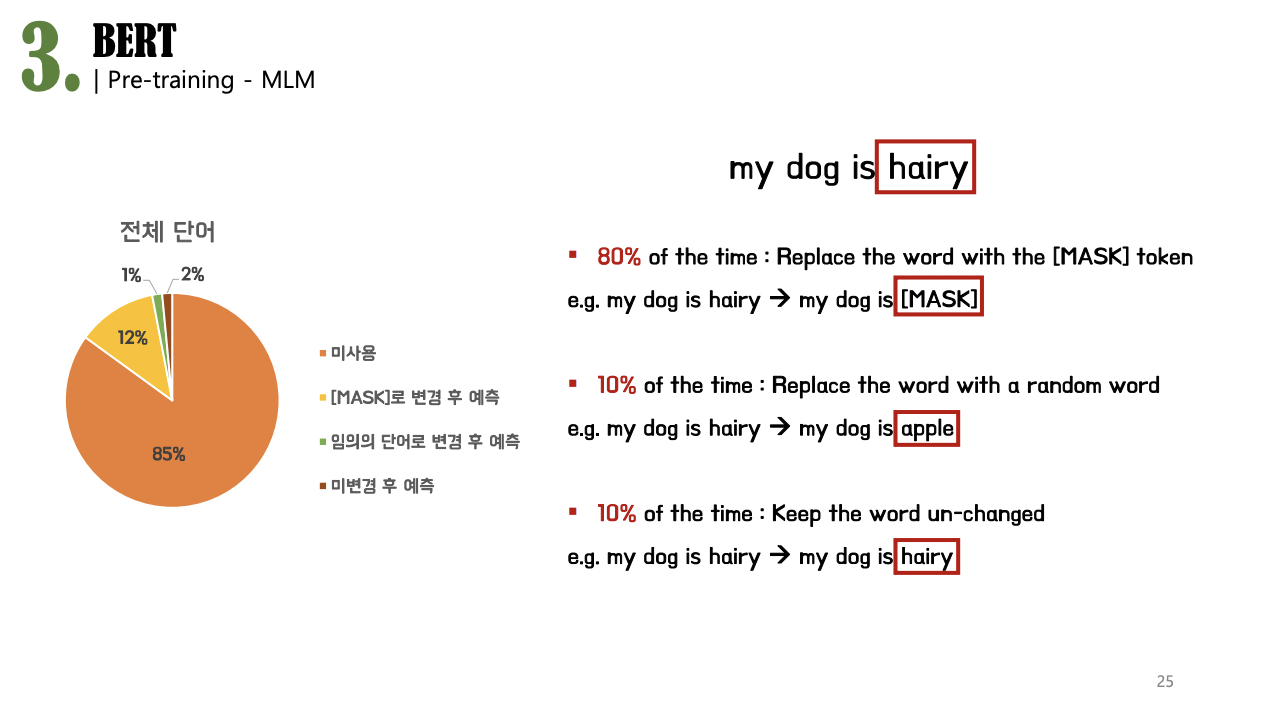

이를 완화하기 위해서 구글 연구진들이 고안해냈던 방법은

학습 데이터 생성기(training data generator)가 전체 인풋 토큰 중 랜덤으로 뽑은 15%의 토큰들을 전부 다 마스킹을 하는 것이 아니라

다음과 같은 일정 비율로 규칙을 적용하여 BERT를 학습시키는 것 이었습니다

오른쪽 논문 부록에서 제시한 예시와 왼쪽에 추가 그림을 함께 보면, 인풋으로 들어온 전체 토큰 중에서 85%는 그대로 두고,

이 랜덤으로 뽑힌 15%의 토큰 중에서의 80%, 전체 인풋 토큰의 12%에 해당하는 토큰을 [MASK] 토큰으로 변경하여, 실제로 마스킹을 해줍니다.

옆의 예시에서 “my dog is hairy”라는 문장이 있습니다. 이 4개의 토큰 중에서, hairy라는 토큰이 BERT가 예측해서 맞추어야 하는 토큰으로 뽑혔다고 가정을 해본다면, hairy와 같이 랜덤하게 뽑힌 토큰들 중 80%는 실제로 [MASK] 토큰으로 마스킹을 해주는 반면, 15% 중의 10%, 즉 1.5%는 마스킹이 아닌, 옆에 “apple”과 같이 전혀 관련이 없는 임의의 다른 단어로 변경을 해주게 됩니다. 그렇게 해서 남은 나머지 1.5%는 되려 마스킹하라는 명령을 어기고, 그저 원래의 단어 “hairy”를 그대로 두게 됩니다.

이 마지막 변경되지 않은 단어에 대해서도 BERT는 해당 단어가 변경된 단어인지 아닌지를 모르기 때문에, 동일하게 예측을 해야 합니다.

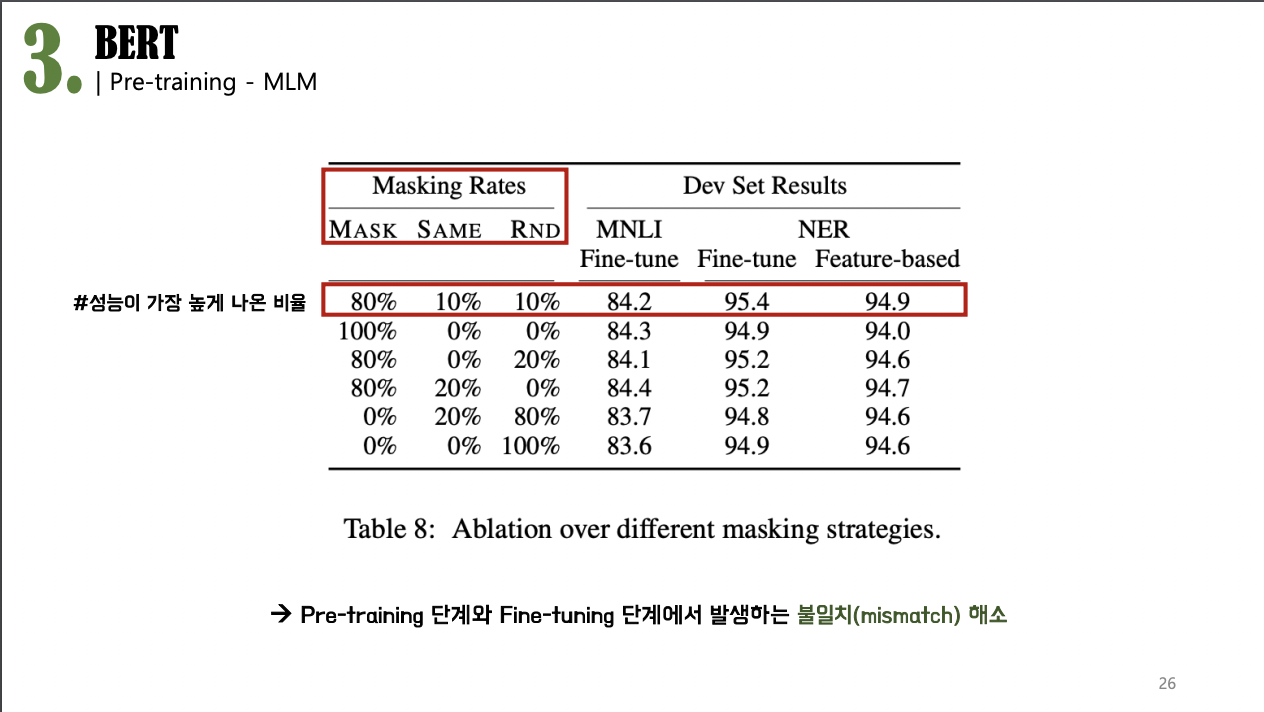

이렇게 랜덤으로 뽑힌 토큰들이 해당 비율로 규칙을 적용하여 학습시킬 때, 일반적으로 가장 좋은 성능이 나왔으며, pre-training단계와 fine-tuning단계에서 발생하는 불일치(mismatch)를 해소할 수 있었다고 논문은 말하고 있습니다.

이런 MLM task로 훈련하는 것의 장점은,

**분산 문맥 표현(distributional contextual representation)**

BERT가 어떤 단어를 예측하도록 질문이 들어올지, 해당 단어가 랜덤으로 변경된 단어인지, 원래 단어인지 전혀 모르기 때문에,

해당 테스크를 이용한 훈련과정은 BERT로 하여금 “단어” 간의 관계를 이해할 수 있도록,

즉 각 인풋 토큰들이 모든 토큰들에 대한 문맥 정보를 가질 수 있도록 하여 문맥을 반영한 임베딩이 가능하도록 해줍니다.

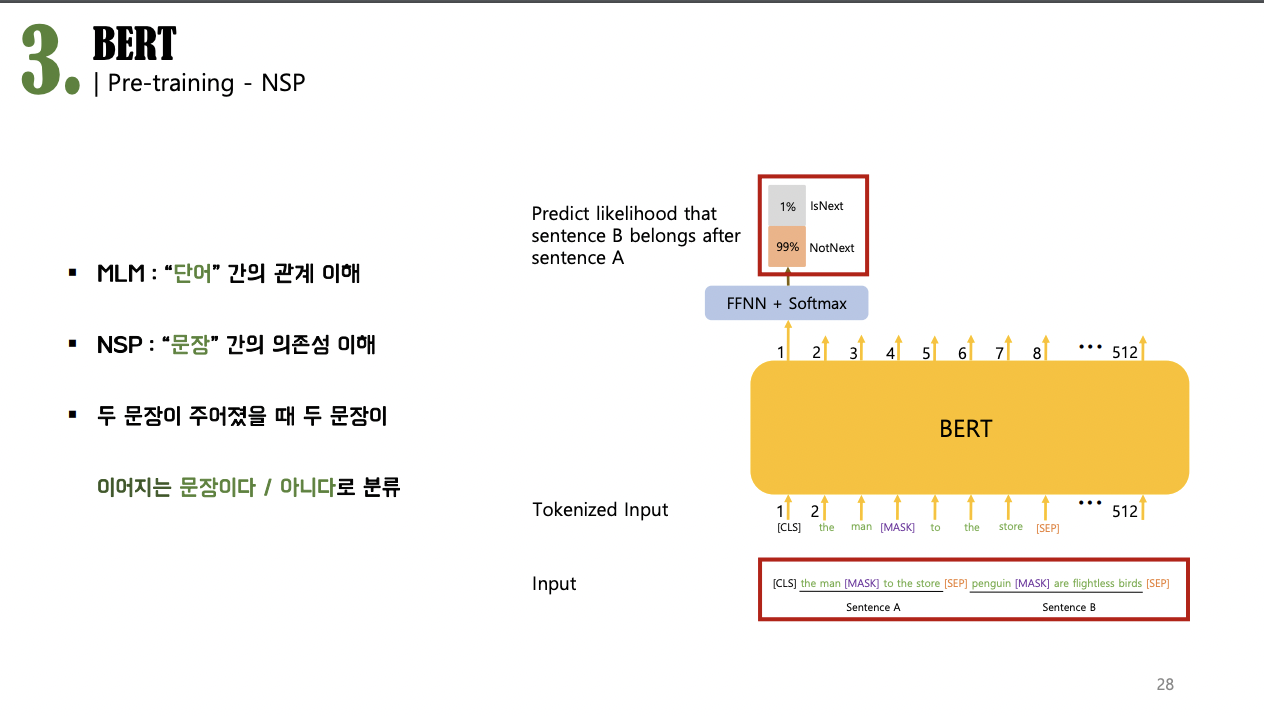

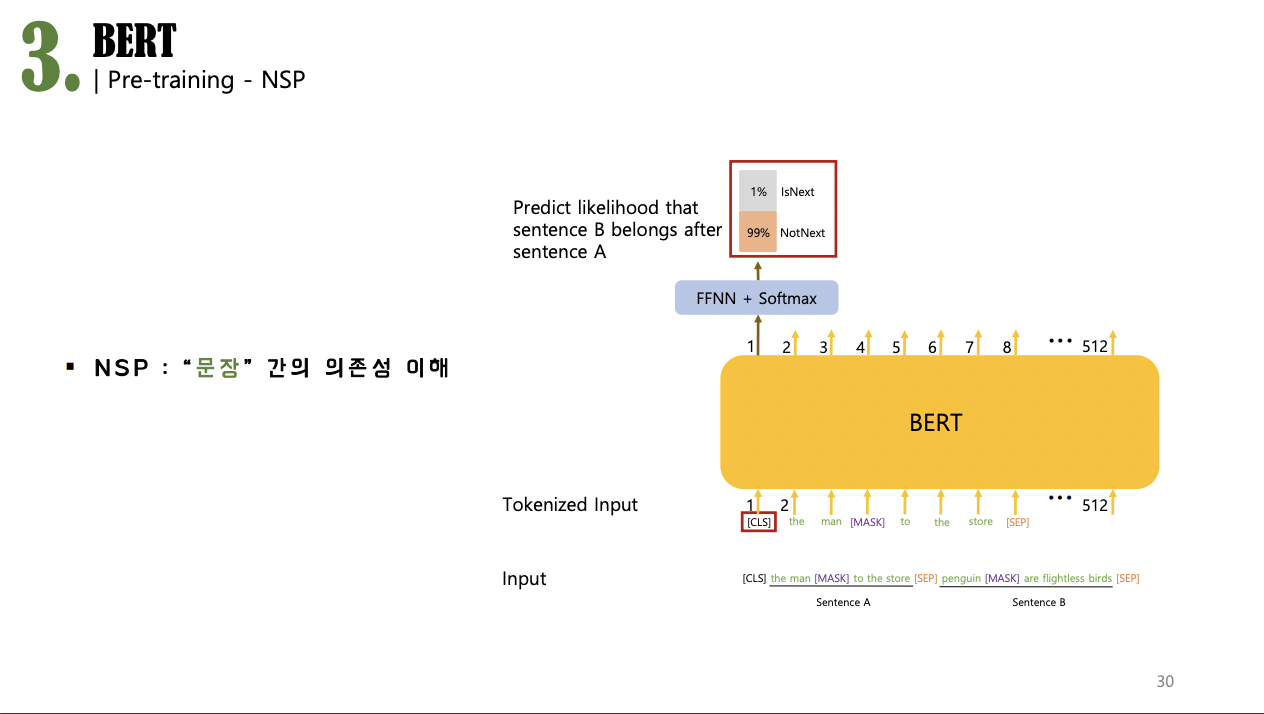

Pre-training의 두번째 방법인 NSP(Next Sentence Prediction)은

MLM이 BERT로 하여금 “단어” 간 관계를 이해할 수 있도록 학습시켰다면, NSP는 BERT로 하여금 더 긴 “문장” 간의 의존성을 이해하도록 학습시킵니다.

예를 들면, 수많은 자연어처리 테스크들 중에서도 질의응답(QA)이나 자연어 추론(NLI)과 같이

두 문장 간의 관계에 대한 이해를 바탕으로 해결해야 하는 자연어 처리 테스크들(sentence-level tasks)은 MLM과 같은 언어 모델링만으로는 부족합니다. 그래서, BERT로 하여금 더 긴 문장 간 관계를 이해시키도록 훈련하기 위해서는 문장 A와 B가 주어졌을 때, 두 문장이 이어지는 문장이다 혹은 아니다로 분류하는 간단한 NSP 테스크를 통해서 사전 훈련을 시키게 됩니다. (binarized next sentences prediction)

자세한 과정은 다음과 같습니다.

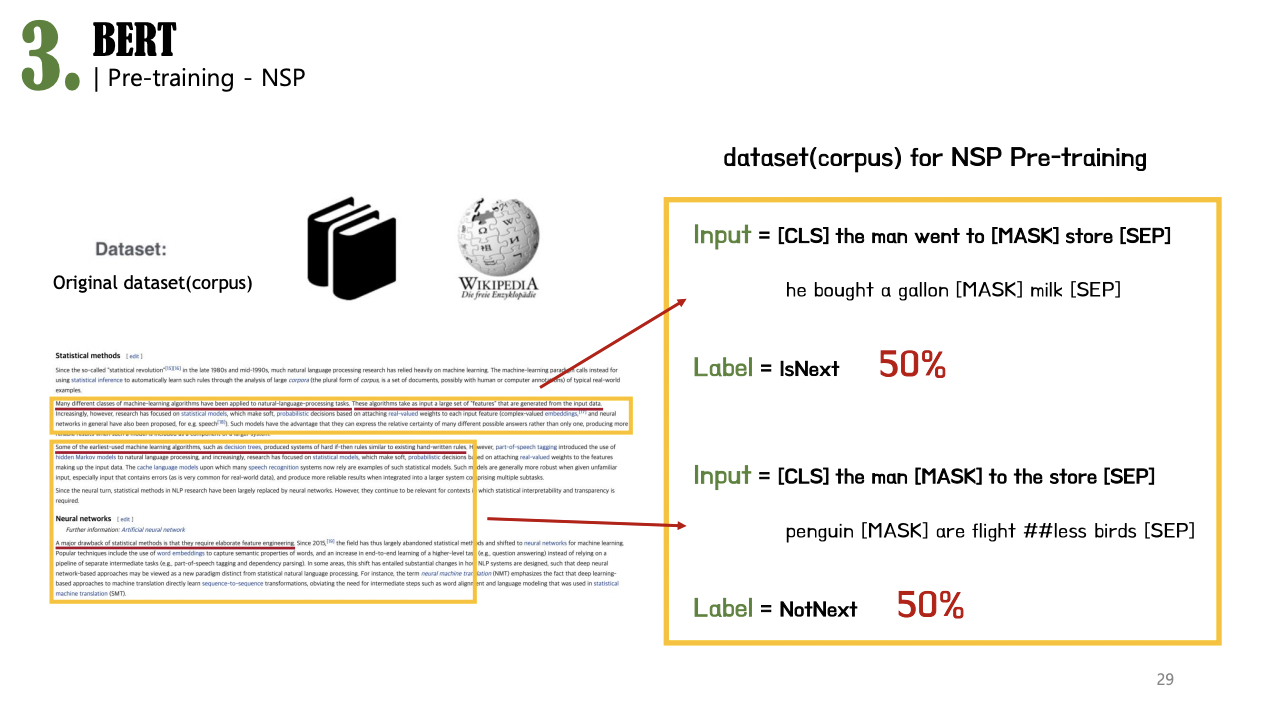

NSP를 위한 사전학습용 코퍼스를 생성할 때, 위키피디아나 북스코퍼스와 같이 라벨링되지 않은 거대한 코퍼스로부터 문장 A와 B를 고르게 되는데,

이때 오른쪽 그림과 같이 NSP 사전학습용 코퍼스 50%는 시퀀스 내 문장 A와 B가 실제로 이어진 문장으로 구성하여 => 즉, IsNext가 라벨링된 시퀀스로 코퍼스가 구성이 되게 되고 나머지 50%는 A와 B가 실제로 이어진 문장이 아닌 랜덤하게 뽑힌 문장으로 구성하여 => NotNext가 라벨링된 시퀀스로 코퍼스를 구성하게 됩니다.

따라서 결론적으로 사전 학습된 BERT 모델을 파인튜닝을 통해 언어들이 잘 임베딩되어 모델들이 테스크를 더 수월하게 해결할 수 있도록 그 임베딩 과정에서 BERT 언어모델을 사용하게 되는 것입니다.