https://getacherryontop.tistory.com/140

트랜스포머와 어탠션 정리 --1

드디어 나를 괴롭히던 어탠션에 관해 이해한 후, 스스로 처음부터 정리해보았다!!! 트랜스포머 등장 전 트랜스포머 전에는 RNN, CNN을 활용한 자연어처리가 이루어졌다. 그러나 이러한 방법은 시

getacherryontop.tistory.com

지난번까지 트랜스포머의 입력과 출력, 어탠션함수에 대해 알아보았다.

인코더와 디코더에 대해 정리하던 중 책에서 좀 이상한 부분이 있어 명확하게 이해되지 않은 부분에 대해 질문을 통해 해결했다!

아무튼 이번에는 트랜스포머의 인코더와 디코더에 대해 정리하겠다.

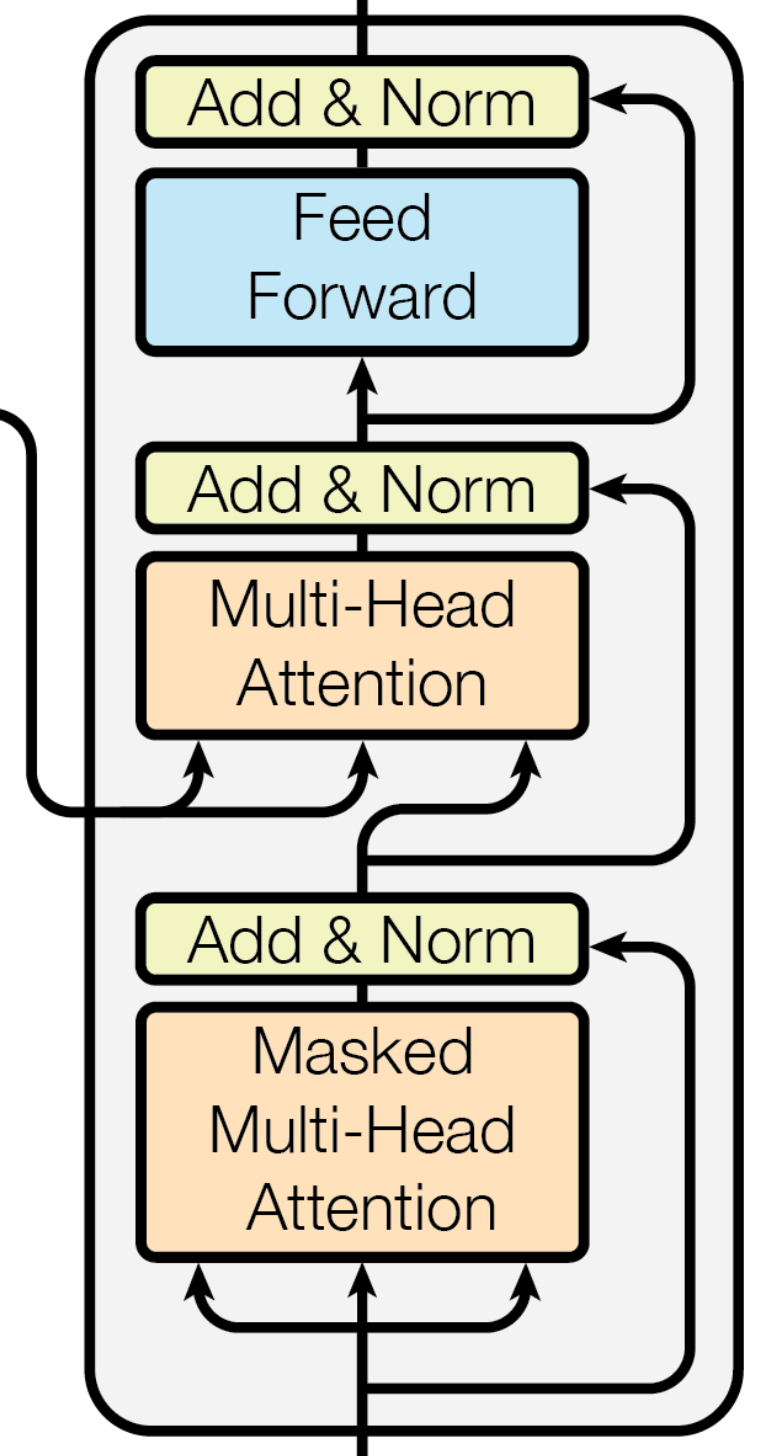

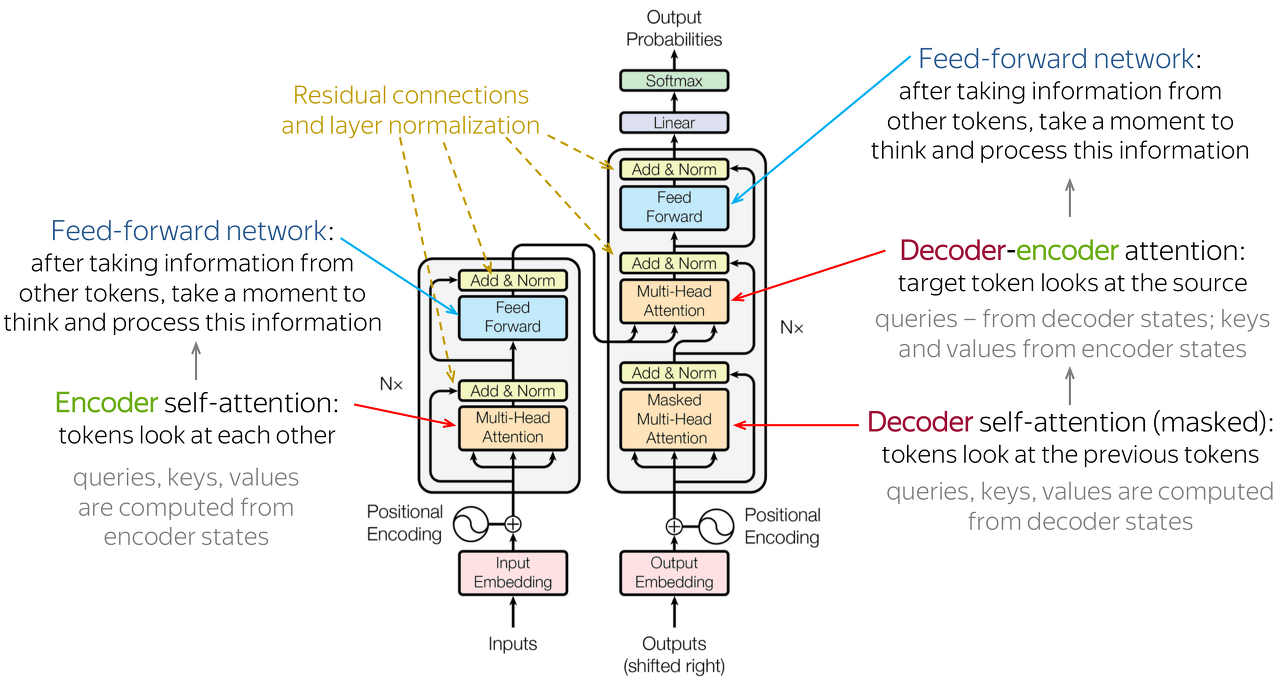

왼쪽 사진인 트랜스포머 전체 구조에서 초록색은 인코더, 빨간색은 디코더이다. 오른쪽 사진은 인코더와 디코더를 간소화한 도식이다.

하나씩 차례로 살펴보자

트랜스포머의 인코더

트랜스포머로 한국어->영어 번역을 하려고 한다. 이를 위해서는 인코더에는 한국어문장이, 디코더에는 한국어에 해당하는 영어문장이 입력으로 들어간다. 저번에 했던 예시문장을 가져와 보면 ,

<한국어->영어 번역>

인코더 입력문장 : '나는 토끼를 키워. 모든 사람이 그를 좋아해.'

디코더 입력문장 : 'I have a rabbit. Everyone likes him.'

을 넣어야 한다.

입력은 저번글에 설명했던 것처럼 input embedding+positional embedding으로 들어간다.

Multi-Head Attention

인코더에서 처음으로 한국어 문장이 마주하는 것은 멀티헤드 어탠션이다. 이때 멀티헤드 어탠션은 셀프 어탠션과 같다.

나는/토끼를/키워/모든/사람이/그를/좋아해 - 하나씩 셀프어탠션을 수행한다.

즉, 쿼리가 '나는' 일때 키는 나는/토끼를/키워/모든/사람이/그를/좋아해 -> attention value 계산,

쿼리가 토끼를 일때 키는 나는/토끼를/키워/모든/사람이/그를/좋아해 -> attention value 계산,,,, 반복하는 셀프어탠션을 하는 것이다 .

물론 1편에서 설명했던 것처럼 쿼리,키 벨류 만들기부터 시작이다!

Feed Forward

Feed Forward NN = FFNN이라고도 한다. (피드포워드 뉴럴네트워크)

앞서 멀티헤드 어탠션의 개별 출력 벡터들을 가지고 계산한다.

Feed Forward 계산 과정

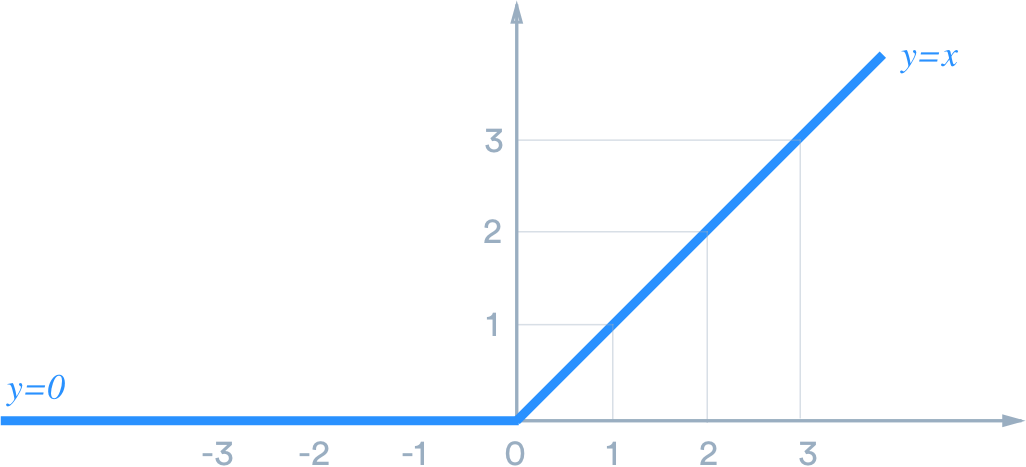

입력층, 은닉층, 출력층을 가진 신경망으로, x에 해당하는 가중차들을 곱한 합에 편향을 더해 은닉층을 생성하고, 활성함수인 ReLU를 통과시킨 값을 출력으로 한다. (트랜스포머에서 활성함수는 ReLU이다)

렐루함수는 양수입력은 그대로 출력하고, 음수입력은 0으로 출력하는 함수이다. f(x) = max(0,x)

python으로 구현해보면 다음과 같다.

b1,b2=1,-1

x= torch.tensor([2,1])

w1 = torch.tensor([[3,2,-4],[2,-3,1]])

w2 = torch.tensor([[3,4],[-3,5],[1,-1]])

hidden = torch.matmul(x,w1)+b1

h = torch.nn.functional.relu(hidden)

y = torch.matmul(h,w2)+b2

참고로 트랜스포머에서는 은닉층의 뉴런개수(=차원 수)를 입력층의 4배로 설정한다. 가령 FFNN의 입력 젝터가 768차원이라면, 은닉층은 12048차원이었다가 출력층에서 다시 768차원으로 줄어든다.

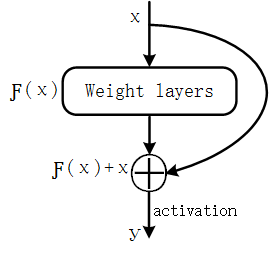

residual connection 잔차 연결

건너뛰기 경로를 하나 둔다고 생각하면 된다. 이렇게!

이렇게 하면 뭐가 좋을까?

경로를 다양하게 둠으로써 학습이 무자비하게 길어짐을 방지하고 좀 더 쉽도록 한다.

Layer Normalization 레이어 정규화

미니배치 단위의 인스턴스(x)별로 평균을 빼주고 표준편차로 나눠 정규화 하는 방법이다.

***논문에서는 이러한 인코더 블록을 6개, 디코더 블록을 6개 쌓았다. 6번씩 반복했다는 것이다. 이 블록은 몇개를 더 쌓을 수도, 덜 쌓을 수도 있다!

트랜스포머의 디코더

마찬가지로 한국어-> 영어 번역을 수행한다고 할때,

디코더 인풋으로 영어 문장을 넣어 준다. 'I have a rabbit. Everyone likes him.'

Masked Multi-Head Attention

앞서 봤던 인코더와 비슷한 멀티헤드 어탠션(셀프어탠션)이다.

차이점 1. 쿼리와 키가 영어 문장이라는 점

차이점 2. masked

- '<s>I have a rabbit. Everyone likes him.</s>'에서 <s>가 주어지면 I 를 맞히도록 학습이 되어야 하는데 셀프어탠션으로 미리 다 알려주면 학습에 도움이 하나도 안됨 따라서 <s>가 주어지면 I 부터는 다 마스킹하여 I를 맞히도록하고, <s> I 가 주어지면 뒤에는 다 마스킹하고 <s> I 로 have 예측하도록 학습하고.... 반복한다.

Multi-Head Attention

- 셀프어탠션이 아니다! 제일 헷갈렸던 부분

엄연히 말하자면 cross attention라고 한다. 자세히 보면 화살표가 인코더에서 오는 것을 알 수 있다. 쿼리에 영어, 키에 한국어 문장 배치 , 인코더에서 넘어온 소스언어(한국어) 문장 정보와 디코더에 타깃문장의 시작을 알리는 토큰 <s>를 넣어 타깃언어(영어)의 첫떄 토큰 생성, 이전에 생성되 타킷언어 토큰 시퀀스를 디코더에 넣어 만든 정보로 다음 토큰을 생성한다. 생성된 문장 길이가 충분하거나 마지막을 알리는 토큰 </s>가 나올때까지 이 과정은 반복된다.

Q1. 트랜스포머에서 멀티헤드 어탠션 = 셀프 어탠션이다?

아니다! 디코더에서 멀티헤드어탠션(Decoder-encoder attention)은 셀프 어탠션이 아닌 크로스 어탠션이다

'자연어 처리 > Today I learned :' 카테고리의 다른 글

| 버트를 활용한 영화리뷰 분류 (0) | 2023.01.16 |

|---|---|

| 허깅페이스의 트랜스포머 🤗 Huggingface's Transformers (0) | 2023.01.16 |

| 트랜스포머와 어탠션 정리 --1 (1) | 2023.01.15 |

| transfomers 를 사용한 간단한 분류 예제(BertForSequenceClassification) (0) | 2023.01.12 |

| Word Embedding (0) | 2023.01.05 |